访答下载安装指南

小艾同学 ... 大约 4 分钟

# 访答下载安装指南

# window 下载与安装

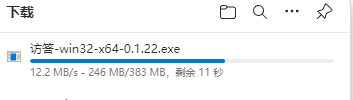

# 下载

访答 window 下载

访答集成了原文档伴侣,新用户直接安装访答即可!有问题直接扫描下方二维码,QQ群联系管理员!

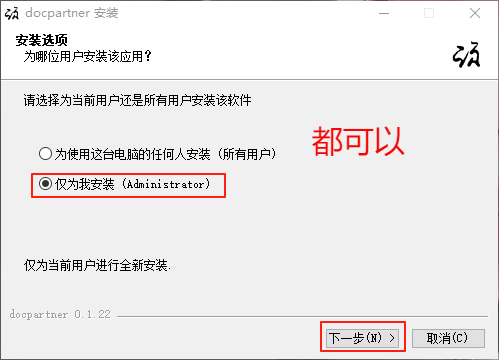

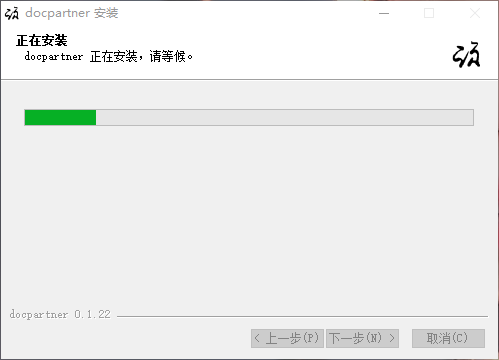

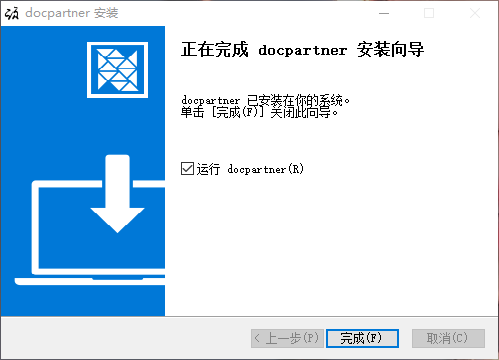

# 安装

# macos 下载与安装

# 下载

访答 macos 下载

# 安装

访答 macos 安装

macos 没有 codesign,会显示打不开docparnter,因为它来自身份不明的开发者,解决方法如下:

系统偏好设置 -> 安全性与隐私 -> 通用选项卡下 -> 点击 仍要打开 docpartner

macos 暂时无法使用本地知识库,云知识库和其他功能正常使用!

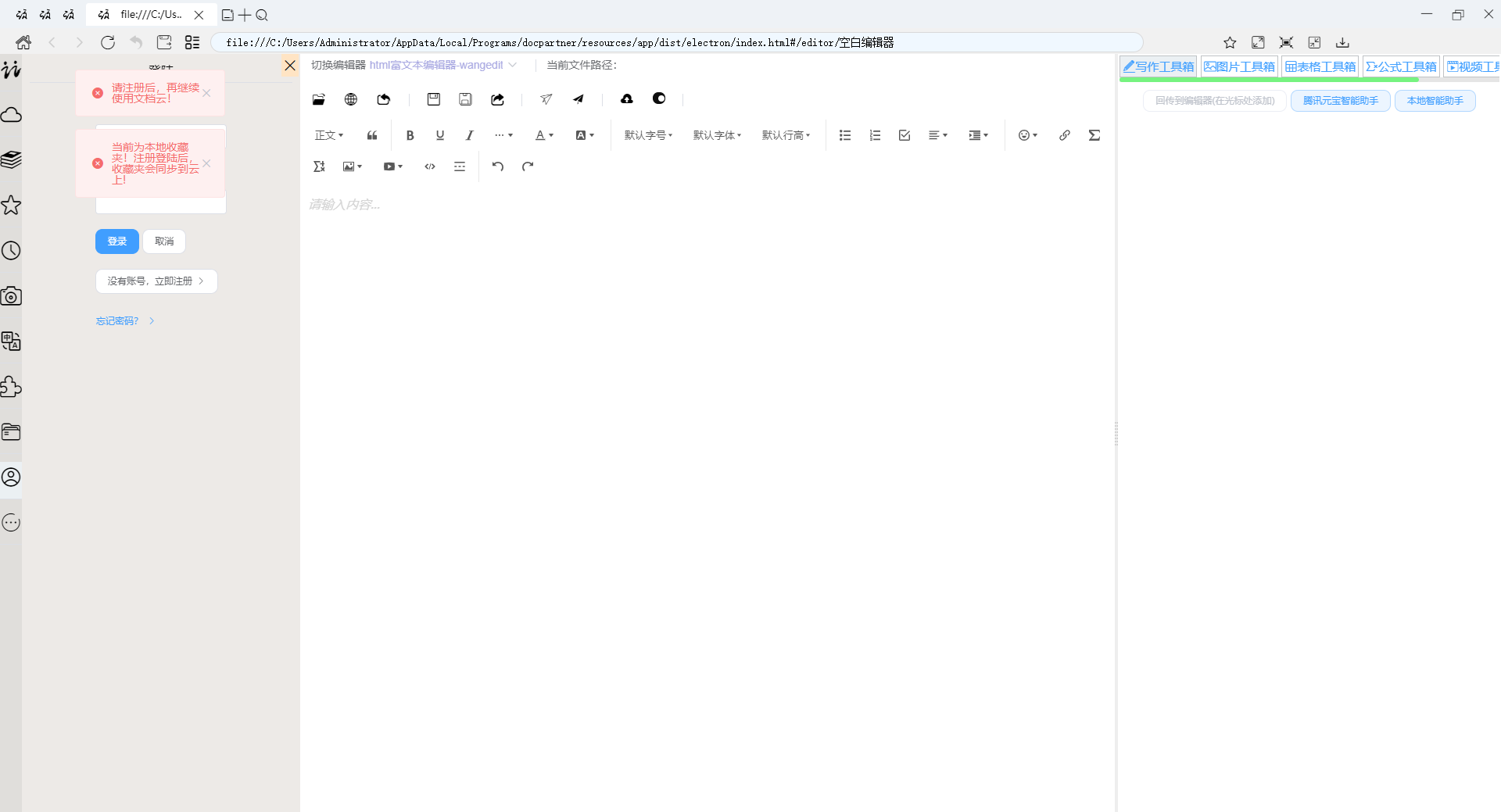

# 双击打开软件

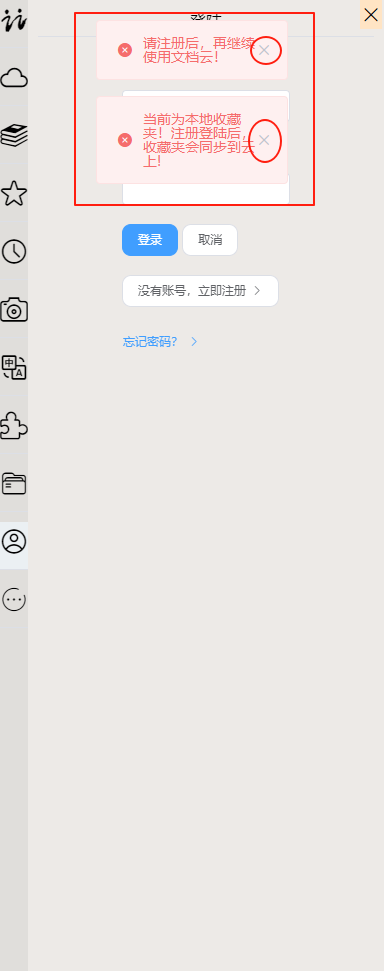

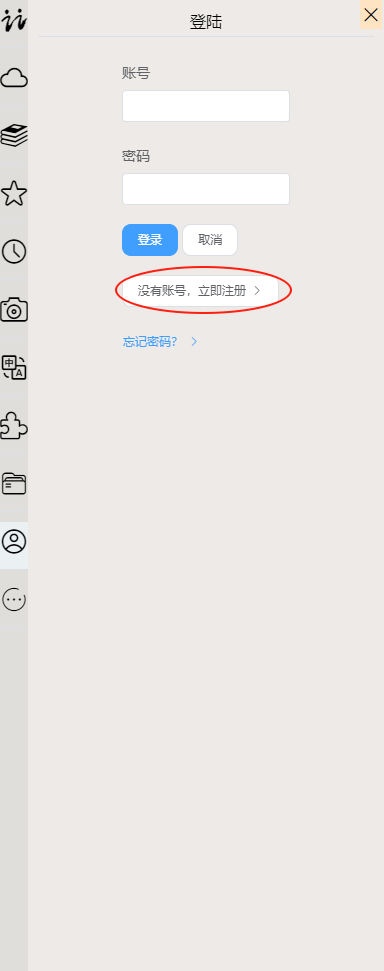

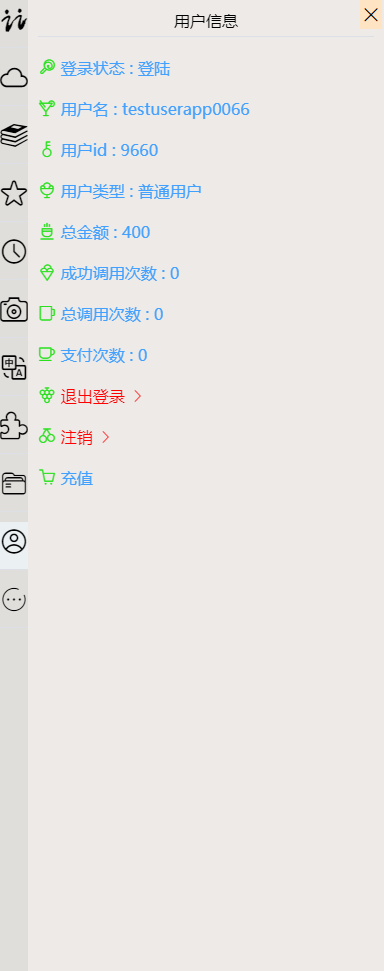

# 注册/登陆

在软件左侧的工具栏中,进行注册登陆

# 至此,除知识库外,访答浏览器、访答编辑器、文档解析OCR、文档转换、文章发布等功能皆可正常使用

# 安装知识库插件

访答知识库插件 下载与安装

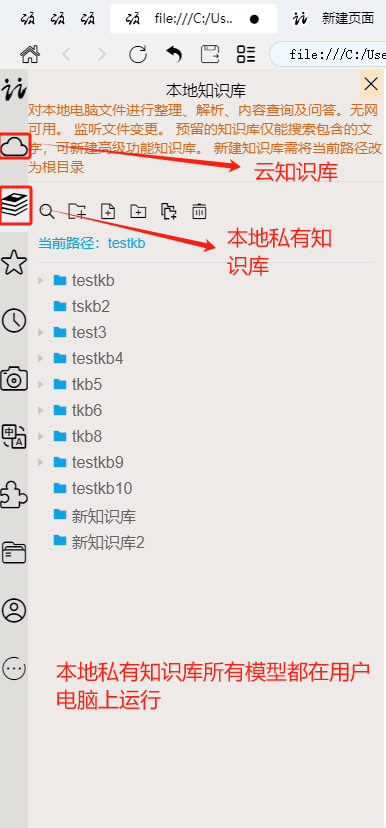

1. 在软件界面左侧的工具栏中,点击云知识库或者本地知识库图标

2. 软件会自动检测到需要安装知识库插件,然后提醒用户安装。用户只需点击确定按键即可

3. Cpu版本和 Gpu版本的区别:Gpu版本知识库插件较大,有显卡时,使用显卡进行计算,速度较快

软件会自动判断使用

Cpu版本还是Gpu版本,只需要按提示选择即可

Cpu版本知识库插件很小,下载安装较快🤗

Gpu版本知识库插件在4G大小左右,下载和安装大概需要6分钟左右!!!请耐心等待~~🤗

# 使用知识库

访答本地知识库使用指南

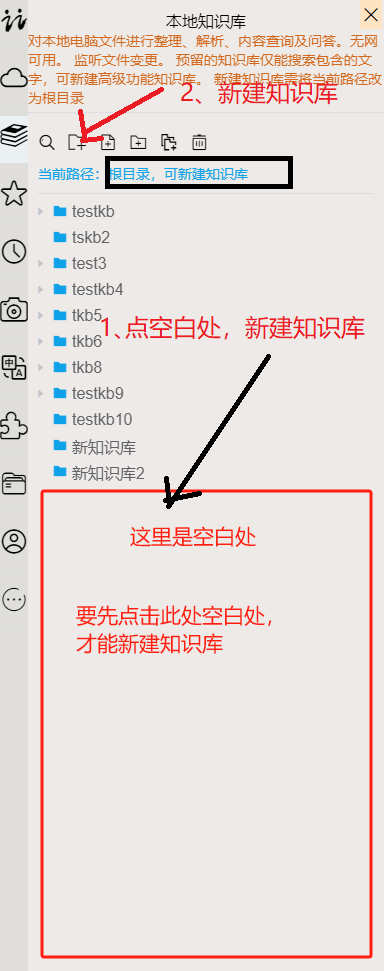

😀新建知识库时,先点击知识库目录下方的空白处,确保当前路径为根目录,再新建知识库

😊本地私有知识库默认预留的知识库是功能最单一的知识库(仅能搜索包含型的文本)。更复杂的知识库功能,请新建知识库进行使用!

😔本地私有知识库只存在当前电脑硬盘中!

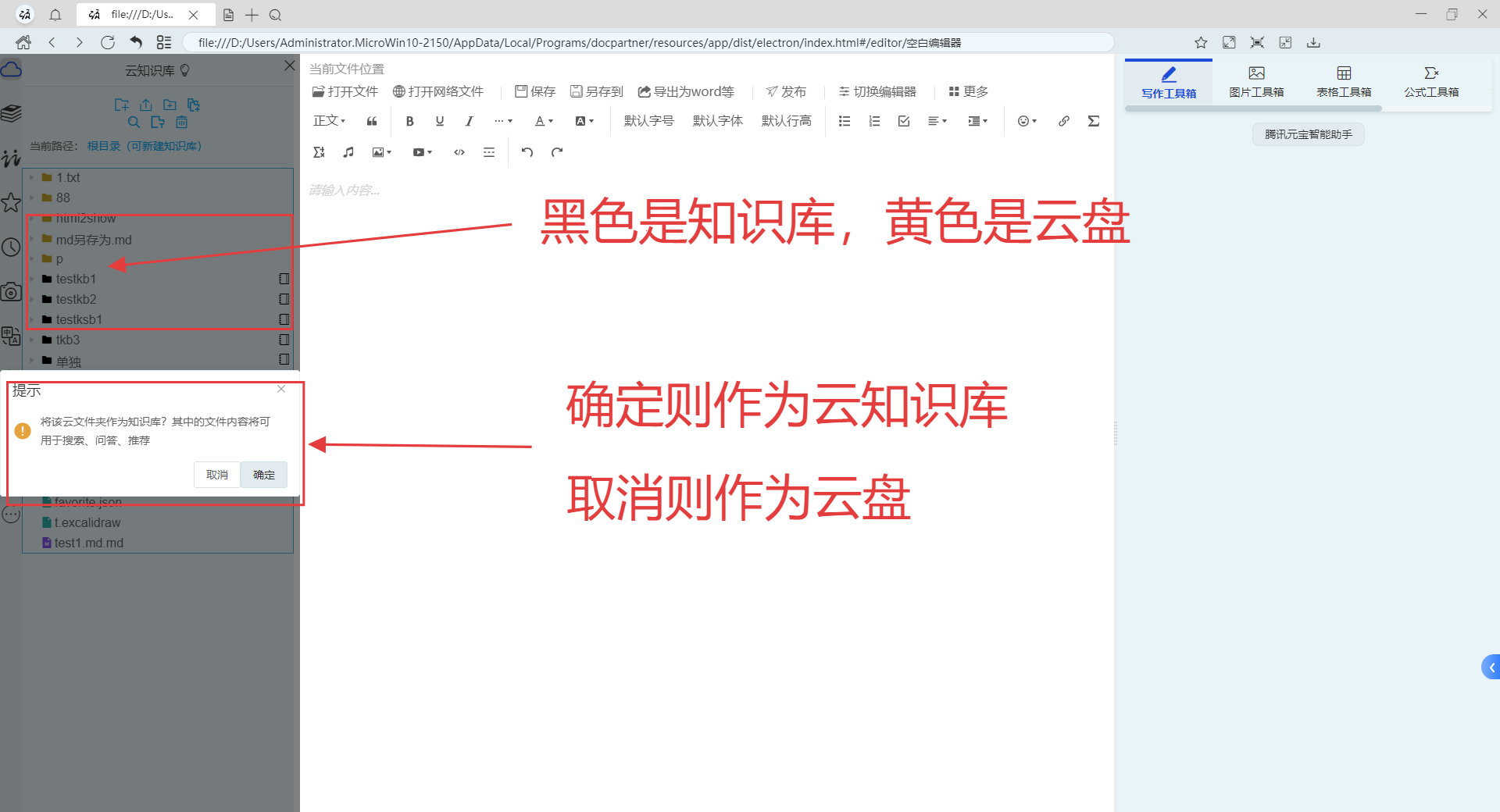

访答云知识库使用指南

😉云知识库中,黑色的是知识库,黄色的是普通云文件夹