模型可配置

# 模型可配置

# 什么是「知识库自定义」?

知识库自定义

知识库自定义 = 文件解析 + 向量模型 + 问答模型 + 算力策略 全流程可配置。

用户仅需修改一份 JSON 即可决定:

- 是否解析视频、PDF、化学结构式等 20+ 文件类型

- 使用哪一款 Embedding / OCR / STT / LLM 模型

- 跑在 本地 GPU 还是 云端 API

- 是否

开启问答、仅搜索或混合模式

默认情况下,

访答会自动根据电脑资源推荐配置,用户只需要点击确定即可

适用场景:

模型定制化、模型私有化、算力受限或有极致效果要求

用户自定义知识库

用户可以直接使用

最先进的AI模型来进行调优,支持任意AI模型的穿插与组合支持各个模型以及架构中的参数调优,直到输出的搜索或问答结果让用户满意为止

用户可以自行配置知识库的行为,例如:

是否解析视频文件是否解析PDF文件

使用什么AI模型来解析PDF文件

使用云上的还是本地的模型来解析图片

是否开启问答模型,不开启则仅搜索使用什么问答模型问答模型是否结合知识库内容,或直接使用网上的知识

文件解析的模型进行配置,如:是否解析数学公式、化学结构式、表格、图片、印章等可配置

云上或本地的deepseek、qwen、qwenvl等,对huggingface和ollama模型进行广泛的支持等等

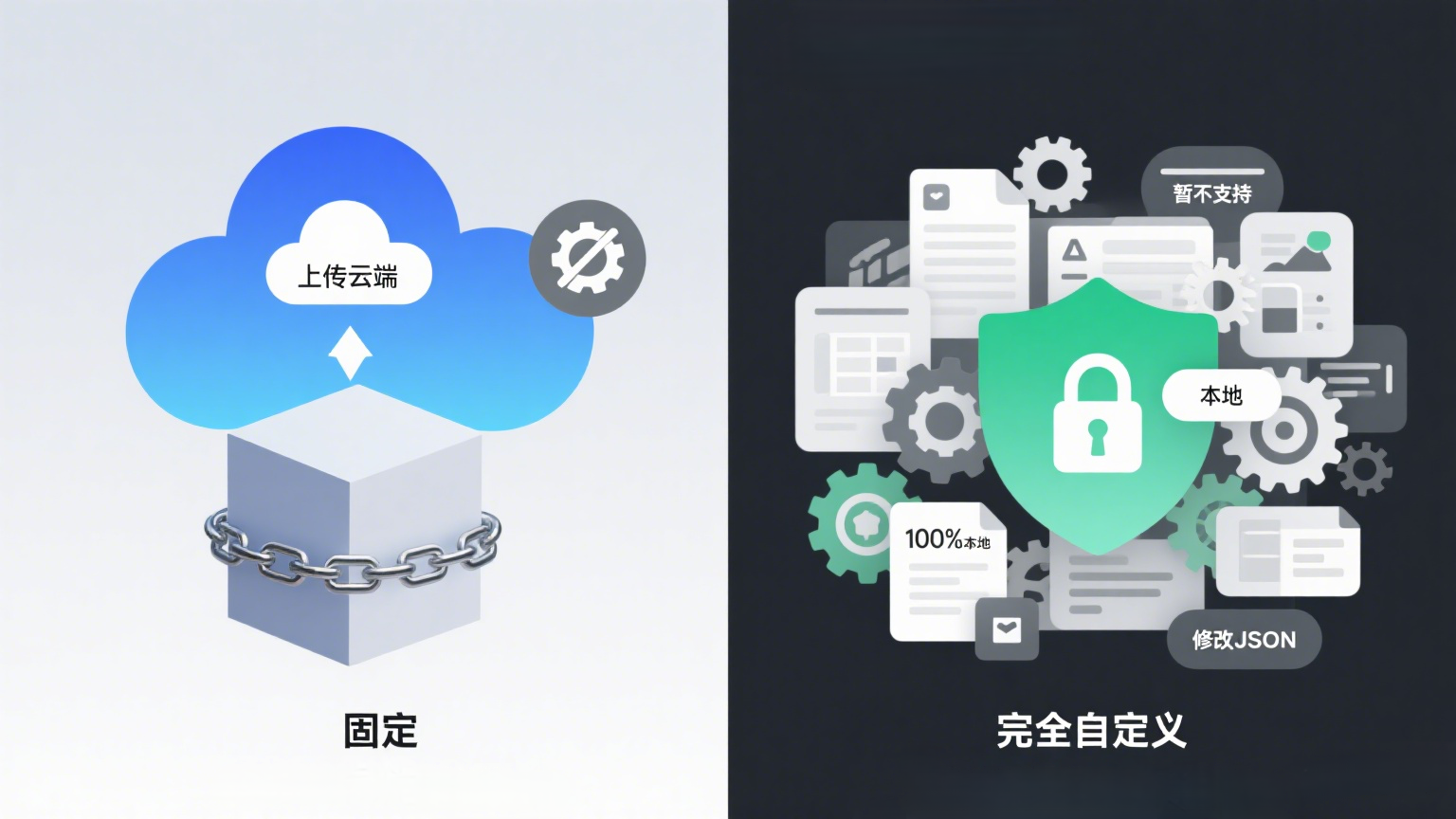

# 云知识库 vs 本地知识库自定义

| 维度 | 云知识库 | 本地知识库 |

|---|---|---|

模型 | 固定 | 任意 HuggingFace / Ollama / 私有权重 |

文件类型 | 完全自定义 | 完全自定义 |

数据隐私 | 上传云端 | 100% 本地 |

配置方式 | 暂不支持 | 修改 JSON |

# 自定义知识库模型

[缺截图]

# Step 1 新建本地知识库

打开软件 → 选择「本地知识库」→ 新建

在弹出的配置选项中,选择

自定义配置

# Step 2 编辑 JSON

自定义配置是一个 json

推荐使用 VS Code + JSON Schema 校验

修改该 json,配置需要的模型

# Step 3 确定

- 点击确定按键,新建知识库即可

云知识库暂时不支持自定义配置。只有本地知识库支持自定义模型。

注意,在修改json时,应该符合 json 语法规则,不加注释、使用""包裹字符串等。

# 完整的配置示例说明

defaultConfigs = {

"isUsed":true, // 是否启用

"serverType":"local", // 整体服务类型

"split":{

"audioSplitTime":30000, // 语音文件分片切割大小,30秒,单位为毫秒

"textSplitLen":512, // 文件切割分片大小

},

"textpdf2htmlEngine":"usePdf2htmlEX", // "usePDFMiner",可编辑的 pdf 转 html 引擎

// 处理的文件中的内容

"handleFileContent":[

"image",

"audio",

"video",

"formula",

"table",

"qrcode",

"barcode",

"chem",

"statchart",

"flowchart"

],

// 处理的文件类型,handleFileContent 内容必须包含在 handleFileType,不能超出

"handleFileType":[

"text",

"image",

"audio",

"video",

"formula",

"table",

"qrcode",

"barcode",

"chem",

"statchart",

"flowchart"

],

// 处理的文件后缀名

"handleFileExt":{

"image":["png", "jpg", "jpeg", "bmp", "gif", "webp", "psd", "svg", "tiff"],

"audio":["wmv","mpg","mpeg","mov","rm","ram","swf","flv","mp3","wma","rm","flv","mpg","mkv","m4a"],

"video":["avi","mp4","rmvb"],

"text":[],

"table":["xlsx", "xls"],

"file":[

"pptx",

"csv",

"doc",

"docx",

"tex",

"md",

"rst",

"odt",

"ipynb",

"adoc",

"markua",

"t2t",

"epub",

"xml",

"pdf",

"html",

"htmls"

] // 复杂文件类型,文件不只是文本,还有图片,语音等

},

// 全文索引

"textsearch":{

// 全文索引可以处理的文件类型,将非文本的转为文本的

"engineExtend_#install#":[

// {

// "key":"meilisearch",

// "name":"meilisearch",

// "type":"web",

// "id":"meilisearch_syy",

// "version":"1.0.0",

// "isNeedStartInHere":true, // 是否在这里启动

// "startCmd":r".\meilisearch.exe --http-addr='127.0.0.1:7700'",

// },

{

"key":"whoosh",

"name":"whoosh",

"type":"python",

"id":"whoosh_syy",

"isNeedInstall":false,

}

],

"handleFileType":[

"text",

"image",

"audio",

"video",

],

// 图片理解模型,用于将图片转为文本

"image2textByLLMVExtend_#install#":[

{

"key":"qwenvl2",

"name":"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4", // 2g:"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4"(4-8g推理,视频推理40g)4g:Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int8(8g推理,视频推理40g) 4g:"Qwen/Qwen2-VL-7B-Instruct"(20g以上推理) 18g // "Qwen/Qwen2-VL-72B-Instruct"

"type":"huggingface",

"device":"cuda",

"gpuSize":int(6*1024),

"id":"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4",

"position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

},

],

// 图片 ocr 模型,用于将图片转为文本

"image2textExtend_#install#":[

{

"key":"rapid",

"name":"rapid",

"type":"python",

"id":"rapid",

"isNeedInstall":false

},

// {

// "key":"dpocr",

// "name":"dpocr",

// "type":"web",

// "id":"dpocr_syy",

// "isNeedInstall":true, // 是 访答 扩展中的扩展插件,如果需要使用,需要先在软件中下载

// "isNeedStartInHere":false, // 是否在这里启动

// },

],

// 语音转文本模型

"audio2textExtend_#install#":[

],

// 视频理解模型,用于将视频转为文本

"video2textByLLMVExtend_#install#":[

],

},

// 语义检索

"semanticSearch":{

"text":{

// 向量特征提取模型

"embedModelExtend_#install#": [

{

"class":"textEmbed",

"key":"AlibabaGte",

"name": "Alibaba-NLP/gte-multilingual-base", // "bce-embedding-base_v1",

"type":"huggingface",

"device":"cuda",

"gpuSize":int(2.5*1024),

"id":"Alibaba-NLP/gte-multilingual-base",

"vecStore":{

"vecEngine":"Chroma", // 向量存储模型

},

"isAsMultiModal":false,

"position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

}

// {

// "class":"textEmbed",

// "key":"ernie",

// "name": "BAAI/bge-m3", // "bce-embedding-base_v1",

// "type":"huggingface",

// "device":"cuda",

// "gpuSize":int(4*1024),

// "id":"BAAI/bge-m3",

// "vecStore":{

// "vecEngine":"Chroma", // 向量存储模型

// },

// "isAsMultiModal":false,

// "position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

// },

],

},

"image":{

"embedModelExtend_#install#":[

], // 向量特征提取模型

},

"audio":{

"embedModelExtend_#install#":[

], // 向量特征提取模型

},

"video":{

"embedModelExtend_#install#":[

], // 向量特征提取模型

},

},

// 智能问答

"qaSearch":{

"llmModelExtend_#install#":[

{

"key":"qwen257b", // NOTE 所有共享,因为属于一次性的模型,不存储

"name":"Qwen/Qwen2.5-0.5B-Instruct", // "Qwen/Qwen2.5-7B-Instruct", "Qwen/Qwen2.5-3B-Instruct",

"type":"huggingface",

"device":"cuda",

"gpuSize":int(4*1024),

"id":"Qwen/Qwen2.5-0.5B-Instruct",

"position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

},

],

"rerankerModelExtend_#install#":[

], // 两阶段模型

},

// 生成

"anygen":{

"text2genExtend_#install#":[

],

"image2genExtend_#install#":[

// {

// "key":"FLUX",

// "name":"black-forest-labs/FLUX.1-dev",

// "type":"huggingface",

// "device":"cpu",

// "id":"black-forest-labs/FLUX.1-dev",

// "position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

// },

],

"video2genExtend_#install#":[

],

"audio2genExtend_#install#":[

],

},

"othermodel":{

"otherModelExtend_#install#":[

// 本地图片鉴黄 模型

// {

// "key":"FalconsaiNSFW",

// "name":"Falconsai/nsfw_image_detection",

// "type":"huggingface",

// "device":"cpu",

// "id":"Falconsai/nsfw_image_detection",

// "position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

// },

]

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

# 示例 - 自定义可处理的文件类型

"handleFileExt":{

"image":["png", "jpg", "jpeg", "bmp", "gif", "webp", "psd", "svg", "tiff"],

}

2

3

上述配置规定了都有哪些类型的 图片 文件可以处理。

# 示例 - 自定义具体视频理解模型

用户可以自定义视频理解模型,或者问答模型等。

如下是一个视频理解模型配置示例,使用了 huggingface 上的视频理解模型

// 图片理解模型,用于将图片转为文本

"image2textByLLMVExtend_#install#":[

{

"key":"qwenvl2",

"name":"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4", // 2g:"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4"(4-8g推理,视频推理40g)4g:Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int8(8g推理,视频推理40g) 4g:"Qwen/Qwen2-VL-7B-Instruct"(20g以上推理) 18g // "Qwen/Qwen2-VL-72B-Instruct"

"type":"huggingface",

"device":"cuda",

"gpuSize":int(6*1024),

"id":"Qwen/Qwen2-VL-2B-Instruct-GPTQ-Int4",

"position":"local", // "local" 表示本地模型,"web" 表示网络模型,配置网络模型会上传文件

},

],

2

3

4

5

6

7

8

9

10

11

12

"device" :"cuda", 也可以是"cpu",GPU不足时,自动切换到CPU"position":"local","local"表示本地模型,"web"表示网络模型,配置网络模型会上传文件。并不是所有的模型都有网络模型,必须是云知识库提供支持的模型才有网络模型。"id"和"name"该保持唯一性,就是huggingface上的模型id。并且尽可能保持二者一致"type"类型,对应的是扩展中的 "type" 类型,可选择如下:exe, 命令行启动的huggingface,huggingface 上的模型web, 需要启动为 http 的python, python 语言本身可以用的模型

# 自定义知识库查询问答模型

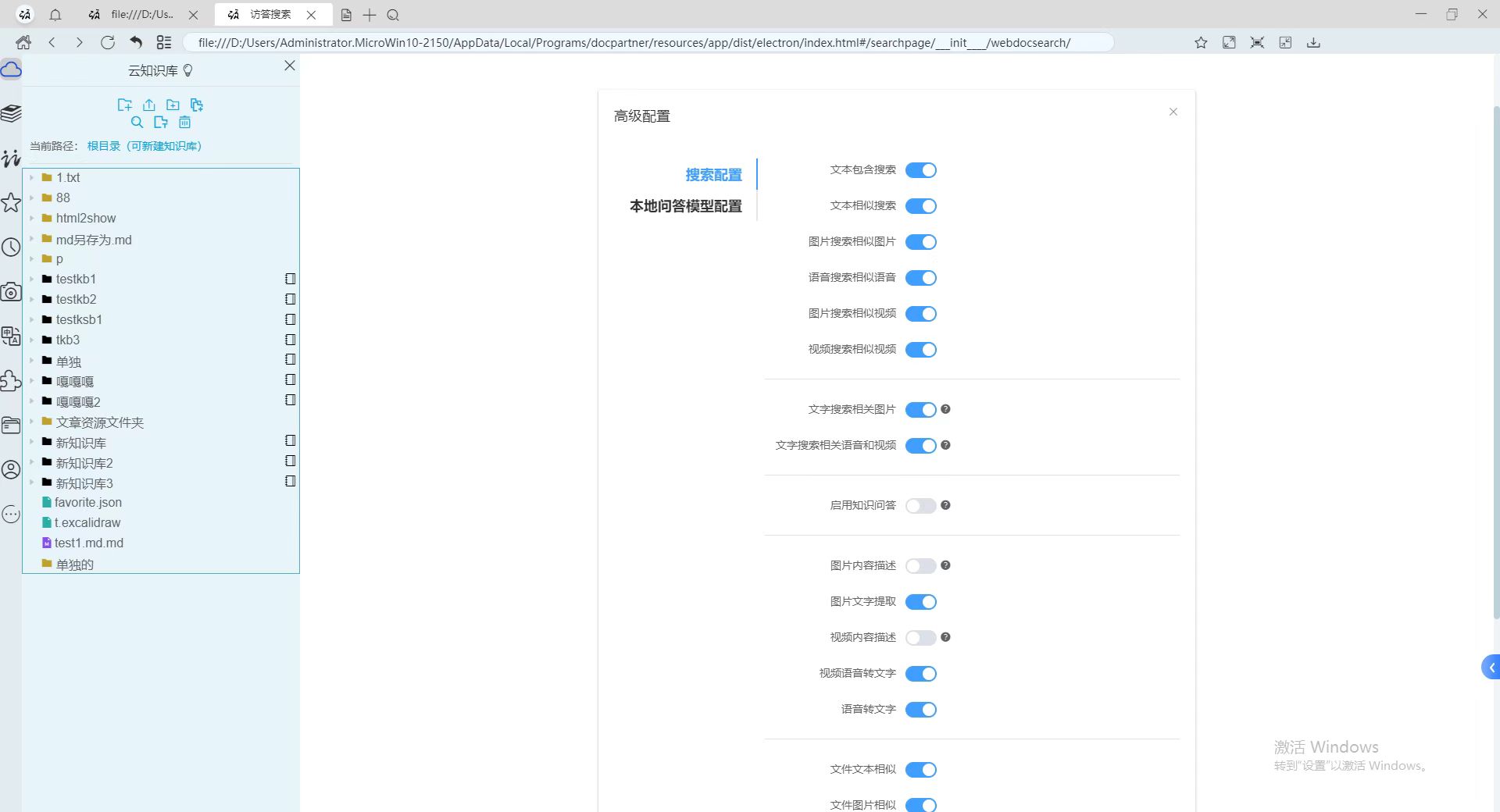

# 高级搜索配置

高级搜索配置

在搜索问答界面,选择配置中的高级配置。

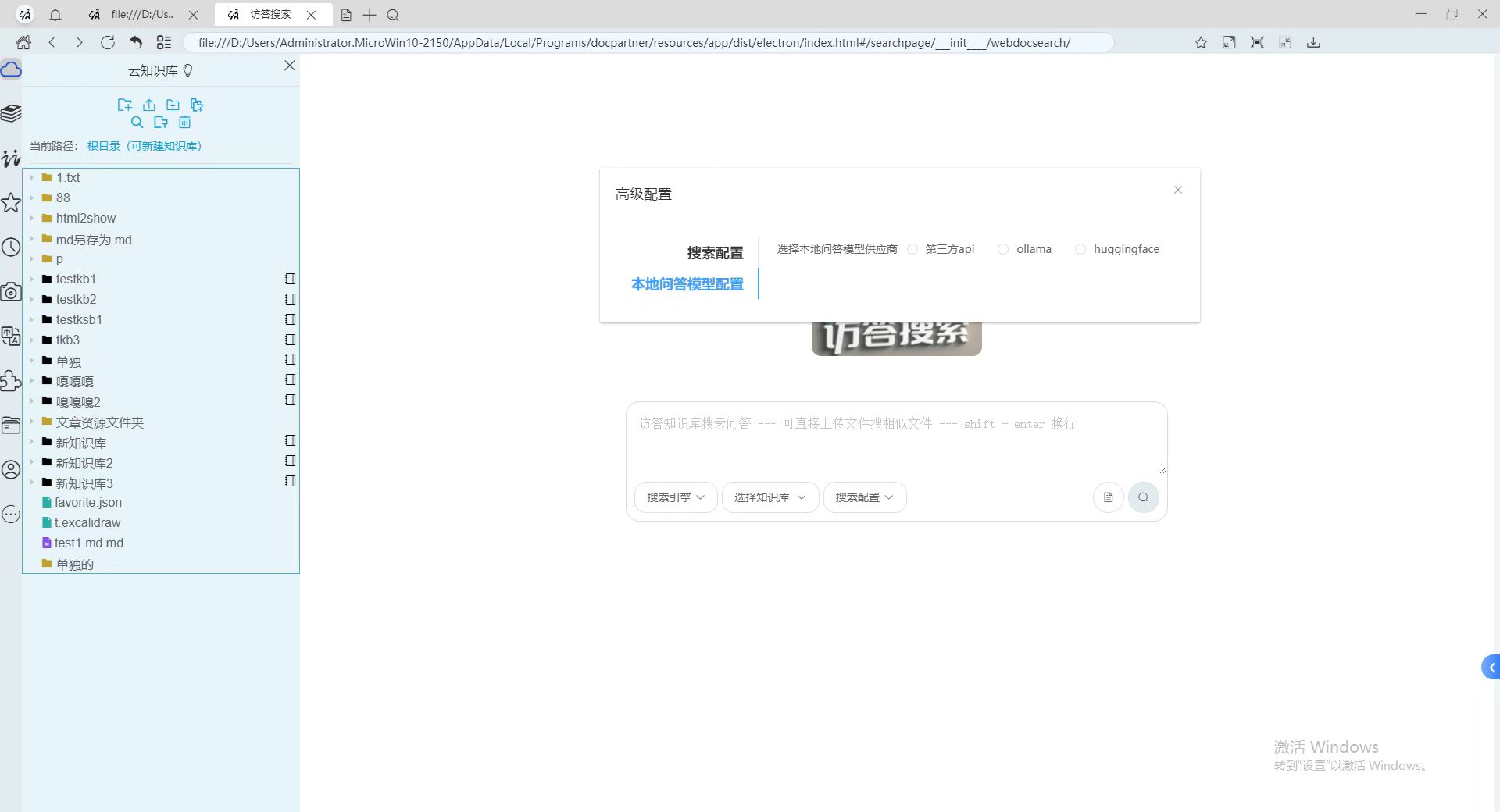

# 本地知识库问答配置

本地知识库问答配置

弹出的界面中,选择本地知识库问答配置。

选择对应的选项。共有三种可选择的情况: 1.可以是

本地配置并已经启动的 huggingface 模型(如果有选项,表示已经启动,并且是默认的配置),2. 或者是ollama模型的http地址,3. 或者是云服务上的 api,或者访答云知识库模型。- 离线方案:

Hugging Face或Ollama,均不依赖外网。 - 在线方案:

云 API或访答云知识库模型,需要网络连接并产生数据上传。

- 离线方案:

# HuggingFace 本地模型

HuggingFace 本地模型

适用:知识库初始化时已将模型下载到本地并启动。

配置:在搜索问答界面 → 配置 → 高级配置 → 本地知识库问答配置,直接选用已显示的 Hugging Face 模型即可。

注意:该方式完全离线,不会上传任何数据片段 。

# Ollama 本地模型

Ollama 本地模型

适用:用户已在本地启动 Ollama 服务。

配置:

- 在

本地知识库问答配置中选择 Ollama; - 填写

http://<host>:11434(默认端口)或其他监听地址。

注意:Ollama 模型需事先通过命令 ollama run <model> 启动,且保持常驻 。

# 云 API / 访答云知识库模型

云 API / 访答云知识库模型

适用:希望通过云端算力或直接使用官方托管模型。

配置:在相同页面选择 云 API 填入对应接口地址与密钥即可。 或选择 访答云知识库模型

注意:该方式需要联网,并会按需上传查询片段 。

注意:

huggingface模型是在知识库初始化时,已经配置并启动好的。ollama模型则需要用户手动启动好,并填写 http 地址。

注意:如果使用

云服务的api,或者访答云知识库模型,需要联网使用,并会上传一些数据片段。而使用huggingface或者ollama模型,则不需要。

云知识库的问答模型是不可以自定义的。

# FAQ

# 立即使用

👉立即免费使用 —— 全自定义的知识库,定义属于你自己的知识库